电信日专稿 | 中兴通讯:加速智能计算生态繁荣

发布时间:2024-05-17

大模型的出现催生了对大算力的需求,端到端开放解耦智算方案是产业良性发展的关键。中兴通讯一直致力于成为端到端开放解耦智算方案提供商,加速AI技术的创新、研发、应用的商业化进程,努力与产业伙伴共同实现共赢的商业生态。近日,《通信产业报》全媒体采访中兴通讯副总裁陈新宇,探讨了中兴通讯如何应对挑战,助力大模型发展与应用的实践和经验。

《通信产业报》:中兴通讯在端到端开放解耦智算方案方面,做了哪些工作和取得怎样的成果。

陈新宇:中兴通讯秉承开放解耦的理念,发挥中兴软件、硬件和工程能力优势,携手合作伙伴构建多渠道供应链,通过硬件、软件和能力平台三个方面的创新,为用户提供端到端的开放解耦智算方案。

中兴通讯副总裁陈新宇表示,中兴通讯认为开放的技术生态才能构建共赢的商业生态,端到端开放解耦智算方案是产业良性发展的关键。

在硬件方面,中兴通讯采用基座灵活、适配多种CPU平台和GPU模组,实现了换芯、换卡、不换座。支持3种CPU平台,并与主流GPU完成了适配,为用户提供了多样化算力,用户就可以根据成本、政策、供货、功耗等不同的需求和情况来灵活选择算力。

在软件方面,通过异构资源管理、训推作业调度和异构集合通信,实现了软硬解耦。向下屏蔽了不同厂家芯片的差异,向上适配了主流AI框架,为模型运行提供了高性能、高可靠性、易迁移的环境。通过软硬协同深度优化,最大化了资源效率。此外,不断研究算力卸载和在网计算技术,以提升算力利用率。

在平台方面,适配主流框架如PyTorch、TensorFlow,实现向后端平台的自动编译和优化,并提供从数据处理、模型开发、训练、优化、评估、部署等端到端的工程工具集,支持全生命周期的保障和管理。同时,提供迁移工具,支持应用全域无感迁移,降低用户迁移成本。

端到端开放解耦智算平台

“百花齐放春满园”,中兴通讯认为开放的技术生态才能构建共赢的商业生态,端到端开放解耦智算方案是产业良性发展的关键。通过软硬解耦、训推解耦、模型解耦,推动各类能力组件化和共享赋能,加速AI技术的创新、研发、应用的商业化进程,构建开放的技术生态;通过产业内的芯片厂商、硬件厂商、模型开发商、应用开发商等形成优势互补,共同做大做强,共同实现智能计算生态的蓬勃发展。

《通信产业报》:大模型的出现催生了对大算力的需求,这给基础设施带来挑战,中兴通讯采取了哪些举措来应对?

陈新宇:当前,集群规模无法满足万亿以上超大模型训练,突破国内大规模集群组网上限势在必行。从GPT3千亿模型到GPT4万亿模型,每年模型参数增长10倍,加上训练token的增长,训练总算力需要提升几十倍。但算力芯片的性能每代只能增长2~4倍,单个集群需要更多的GPU卡数才能满足万亿大模型训练需求。

为了构筑更大规模的算力集群,中兴通讯从机内和机间两个维度,不断研究优化GPU卡间高速互联技术方案,满足万亿以上大模型训练需求。在机内,提出了开放的OLink互联协议,突破机内TP8限制,支持16张到128张GPU超级计算节点的大TP算力;在机间,通过集大容量交换芯片能力的不断演进,提供基于标准RoVEv2协议的交换机框盒互联方案,满足从千卡到万卡超大规模算力的灵活组网需求。

《通信产业报》:随着智算基建的完成和大模型训练的成熟,行业应用落地成为最大的挑战,中兴通讯有什么解决方案?如何推动AI应用商业闭环?

陈新宇:企业在AI技术应用方面存在短板,同时私有数据的保护限制了模型训练的有效性。此外,不同行业、不同企业的个性化需求也增加了应用落地的复杂性。

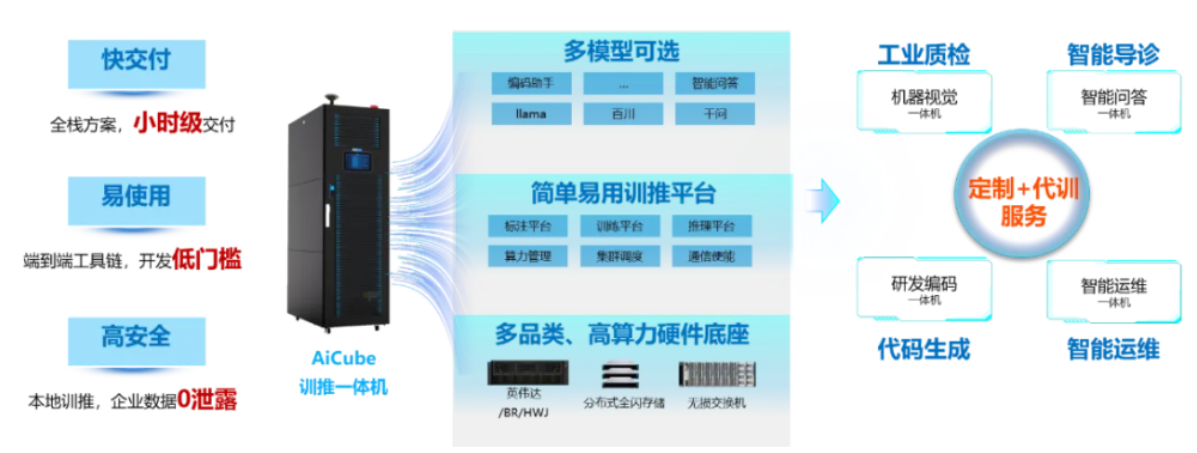

为解决这些问题,中兴通讯提出引入AiCube训推一体机的解决方案。在软硬件方面,提供多品类高算力硬件底座和易用的训推平台,内置主流大模型和AI应用。在服务方面,提供定制化服务和代训服务。

为推动行业应用落地,中兴通讯与行业伙伴紧密合作,推出多种一体化解决方案。例如,针对工业质检领域,提供机器视觉一体机;针对医疗行业,推出智能导诊的智能问答一体机。用户不需要专业技术积累,不需要大规模投资,不需要专业机房,不需要专业团队,就可以构建自己的专属大模型,用AI提升生产力。智、算、用一体化部署可大幅降低AI推广门槛,加速行业市场规模化商用。

中兴通讯AiCube训推一体机

在AI应用商业化进程中,训推并举才能加速商业闭环。中国拥有众多且丰富的应用场景和私域数据,这是在全球AI竞争中最大的优势之一。在应用方面,中兴通讯利用自研或开源基础大模型,结合丰富的行业数据和知识工程,构建领域大模型,打造行业样板,实现从“0”到“1”的突破。基于领域大模型,结合不同场景,实现从“1”到“N”的应用拓展。

在市场方面,C端市场需求相对一致化,因此采用云端部署更为合适。而在B端市场,由于还在探索和孵化应用场景,同时受限于私域数据安全等考量,客户更希望采用私域部署形式。因此,中兴通讯提倡以终为始,打造中心云到专属云的全链路服务。中心云支持基于通用数据的大模型预训练和云端推理,而专属云则提供基于私域数据的本地精调和推理。这样的服务模式由运营商进行建设维护,企业进行租用,能更好地满足客户需求,加速大模型在不同场景的落地和应用。

《通信产业报》:大模型引领行业变革,中兴通讯在大模型及应用方面有哪些实践?

陈新宇:在大模型及应用方面,中兴通讯采用“1+N+X”策略,基础大模型采用自研与生态合作并举,并在此基础上通过领域知识增量预训练“N”个领域大模型,包括研发大模型、工业大模型、通信大模型、政务大模型等,进而衍生出“X”种应用,构筑产业数智化转型新引擎。

其中,在研发领域,研发代码大模型辅助公司开发人员编码效率提升30%;在生产制造领域,在公司南京滨江基地,通过工业大模型将订单排产时间缩短88%、工艺文件生成效率提升50%;在通信领域,在乌镇世界互联网大会上,基于通信大模型的重保助手可一键生成重点事件保障方案,相比于传统保障流程,保障效率可提升80%。

业界首个基于大模型的“智御”反诈系统应用,针对百万级诈骗短信样本进行增量训练,可结合上下文语义关联信息,精准识别经过各种变异干扰的垃圾短信,拦截准确率提升至99%;在水利领域,基于水利大模型实现多轮对话、意图识别、知识问答等,助力水利知识平台建设,河道知识问答准确率达90%;在城市生命线安全工程领域,率先用大模型实现对燃气、积水、道路隐患等多种风险的视觉智能识别,自动生成应急处置预案,保障人民群众的生命财产安全。